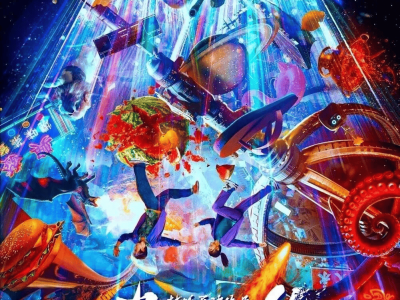

蘋果公司近日宣布,與中國人民大學聯合研發的VSSFlow新型人工智能模型取得重大突破。這一創新成果成功打破傳統音頻生成技術的局限,通過單一系統即可從無聲視頻中同步生成逼真的環境音效與自然人聲,為多媒體內容創作開辟全新路徑。

傳統音頻生成領域長期存在功能割裂的困境:視頻轉語音模型(V2S)難以處理復雜語音細節,文本轉語音模型(TTS)則無法捕捉環境聲場特征。行業普遍采用的"分階段訓練"方案不僅增加系統復雜度,更因任務沖突導致性能衰減。VSSFlow通過10層架構設計與"流匹配"技術的創新融合,首次實現從隨機噪聲到目標聲音信號的端到端重構。

研發團隊在訓練過程中意外發現聯合訓練的協同效應。實驗數據顯示,當同時輸入環境音視頻、字幕對話視頻及純文本語音數據時,模型展現出跨模態學習能力——語音訓練數據顯著提升環境音效的真實度,而環境聲場信息則優化了語音的韻律表現。這種"數據互助"機制使模型在復雜場景下的表現尤為突出。

在實際應用中,VSSFlow采用雙軌處理機制:以每秒10幀的速率提取視覺特征生成環境音效,同時通過文本腳本精準控制語音生成。這種設計使系統能夠同步處理動態場景中的多重聲源,無論是雨滴敲擊窗欞的細微聲響,還是多人對話的復雜聲場,均可實現像素級的聲音還原。

基準測試表明,VSSFlow在語音清晰度、環境真實度、多聲源分離等核心指標上全面超越專項模型。其生成的音頻樣本在盲測中被專業人士誤認為真實錄音的比例達到87%,較傳統方案提升42個百分點。目前研發團隊已將核心代碼開源至GitHub,并計劃陸續公開預訓練模型權重及在線演示平臺。

這項突破不僅為影視后期制作、游戲開發等領域提供高效工具,更可能重塑虛擬現實、智能助手的交互范式。隨著模型持續優化,未來用戶或可通過簡單視頻輸入,即可獲得包含完整聲效的沉浸式內容,大幅降低多媒體創作的技術門檻。