人工智能領域迎來一項突破性進展,DeepSeek團隊在GitHub平臺開源了名為Engram的創新技術模塊,并同步發布題為《通過可擴展查找實現條件記憶:大語言模型稀疏性的新維度》的學術論文。這項研究通過解耦知識存儲與邏輯推理兩大核心功能,為提升模型效率開辟了全新路徑。

傳統大語言模型普遍采用Transformer與專家混合(MoE)架構,通過動態激活部分參數實現計算成本控制。但研究發現,現有架構在處理事實性記憶(如固定知識問答)與邏輯推理(如代碼調試)時存在顯著效率差異。以DeepSeek系列模型為例,盡管MoE架構有效緩解了參數量激增帶來的計算壓力,但在處理需要精確記憶的任務時仍存在優化空間。

Engram技術的核心創新在于構建了獨立的記憶處理通道。該模塊通過哈希算法將輸入文本切分為N-gram片段,并映射至可學習的查找表,實現O(1)時間復雜度的確定性檢索。這種設計使模型在保持參數規模的同時,將記憶存儲與邏輯計算徹底分離——靜態記憶通道負責快速檢索已知模式,動態計算通道專注處理復雜推理任務。

技術實現層面,Engram模塊被嵌入Transformer架構的早期階段。當輸入文本進入模型時,該模塊首先進行模式重建,將相關背景知識檢索出來作為后續計算的輸入素材。與傳統自注意力機制不同,這種條件化記憶檢索機制會根據上下文隱狀態動態調整檢索策略,確保提取的記憶片段與當前任務高度相關。

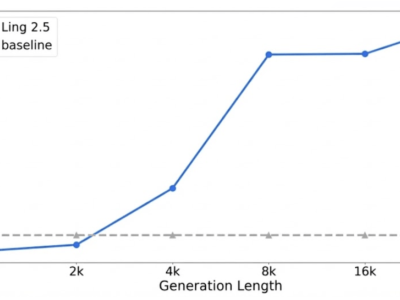

實驗數據顯示,在270億參數規模的測試模型中,Engram模塊可占用高達60%的參數用于記憶存儲,但在實際推理過程中僅消耗極少量計算資源。這種參數分配策略使模型在知識調用、數學推理等任務上的表現顯著提升,同時保持了與全參數模型相當的計算效率。研究團隊特別指出,Engram與MoE架構形成互補關系:前者處理記憶檢索的"已知已知",后者專注邏輯推理的"未知未知",二者協同構成更高效的雙系統架構。

技術社區對這項創新給予高度關注。Reddit平臺上的開發者討論指出,Engram通過引入靜態記憶維度,解決了MoE架構在模式重建方面的固有缺陷。有評論認為,這種確定性尋址機制使得模型可以將龐大記憶表卸載至主機內存,在幾乎不增加推理開銷的情況下擴展知識容量。另有開發者指出,該技術與傳統NLP中的n-gram嵌入存在理念相通之處,但通過現代化改造實現了質的飛躍。

關于技術落地,社區猜測Engram可能成為DeepSeek下一代模型的核心組件。X平臺上的技術分析認為,這種記憶-推理分離架構預示著大模型發展將進入新階段,未來可能出現更多針對特定任務優化的專業化模塊。有開發者調侃,這項來自中國團隊的創新或將改變行業技術路線,甚至引發新的"抄襲"競賽。

目前,Engram的完整代碼與論文已在GitHub公開,開發者可自由訪問實現細節。這項研究不僅為大模型架構設計提供了新思路,其開源特性也將推動整個領域的技術進步。隨著更多研究者參與優化,基于查算分離原理的新型模型架構有望在不久的將來實現更廣泛的應用突破。