蘋果公司與中國人民大學聯(lián)合研發(fā)的VSSFlow人工智能模型,近日在音頻生成領(lǐng)域?qū)崿F(xiàn)重大突破。該模型通過創(chuàng)新性的技術(shù)架構(gòu),成功解決了傳統(tǒng)方案中環(huán)境音效與語音生成難以兼顧的難題,能夠在單一系統(tǒng)內(nèi)同時生成與視頻畫面高度匹配的背景音和清晰人聲。

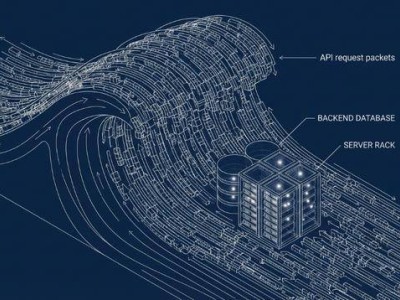

傳統(tǒng)音頻生成技術(shù)存在顯著短板:視頻轉(zhuǎn)聲音模型(V2S)雖能捕捉環(huán)境聲卻難以生成清晰語音,文本轉(zhuǎn)語音模型(TTS)雖可輸出標準人聲卻無法處理復雜環(huán)境噪音。此前行業(yè)普遍采用分階段訓練方案,將兩類模型串聯(lián)使用,但這種架構(gòu)不僅增加系統(tǒng)復雜度,更因任務沖突導致性能損耗。VSSFlow團隊通過10層神經(jīng)網(wǎng)絡架構(gòu)與"流匹配"技術(shù)的結(jié)合,使模型具備從隨機噪聲中自主重構(gòu)目標聲音信號的能力。

研發(fā)過程中,團隊意外發(fā)現(xiàn)聯(lián)合訓練帶來的協(xié)同效應。當模型同時接觸包含環(huán)境音的視頻、帶字幕的說話視頻及純文本語音數(shù)據(jù)時,語音訓練數(shù)據(jù)顯著提升了環(huán)境音效的生成質(zhì)量,而環(huán)境音效數(shù)據(jù)則優(yōu)化了語音的自然度。這種數(shù)據(jù)融合訓練方式,使模型能夠精準區(qū)分不同聲音元素的生成邏輯。

在實際運行中,VSSFlow采用雙軌處理機制:以每秒10幀的速率提取視頻中的視覺特征作為環(huán)境音效生成依據(jù),同時通過文本腳本解析控制語音輸出的內(nèi)容與節(jié)奏。這種設計使模型既能生成雨聲、腳步聲等細節(jié)豐富的環(huán)境音,又能保持對話語音的清晰度和情感表達。

第三方測試數(shù)據(jù)顯示,VSSFlow在環(huán)境音自然度、語音清晰度、音畫同步率等核心指標上,均超越專門針對單一任務設計的競品模型。目前研發(fā)團隊已將完整代碼開源至GitHub平臺,并正在籌備模型權(quán)重公開及在線演示系統(tǒng)的開發(fā)工作。這項技術(shù)有望為影視制作、游戲開發(fā)、虛擬現(xiàn)實等領(lǐng)域提供更高效的音頻生成解決方案。