近日,人工智能領(lǐng)域迎來重要進展,智譜正式發(fā)布并開源了GLM-4.7-Flash模型。該模型作為混合思考模型,總參數(shù)量達30B,激活參數(shù)量為3B,憑借出色的性能與效率,成為同級別SOTA(State-of-the-Art)模型中的佼佼者,為輕量化部署提供了全新且優(yōu)質(zhì)的選擇。

即日起,GLM-4.7-Flash將取代GLM-4.5-Flash,在智譜開放平臺BigModel.cn正式上線,并且可供用戶免費調(diào)用。這一舉措無疑為廣大開發(fā)者及相關(guān)從業(yè)者提供了更為便捷、高效的工具,有助于推動人工智能技術(shù)在更多領(lǐng)域的應(yīng)用與發(fā)展。

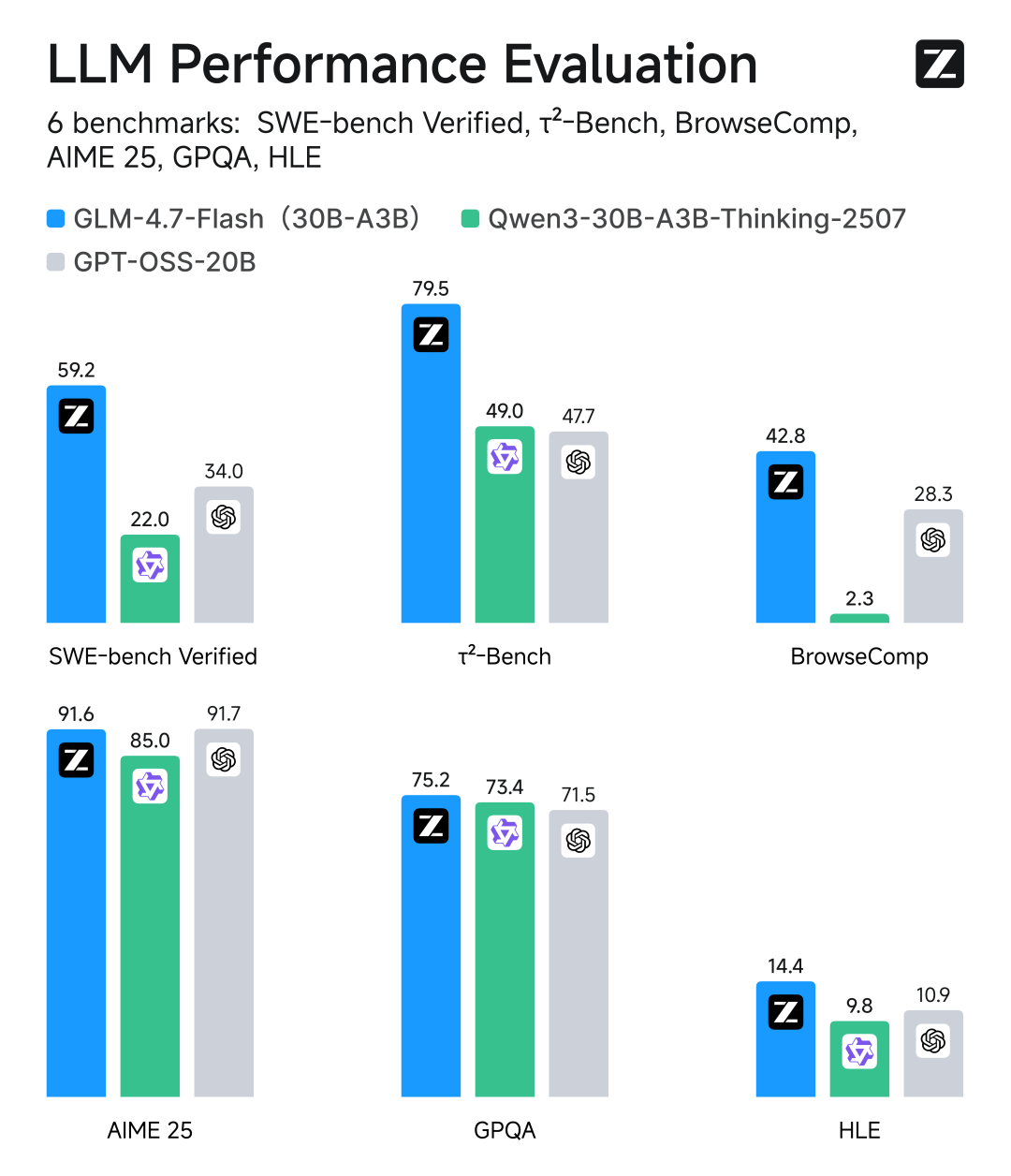

在性能表現(xiàn)方面,GLM-4.7-Flash在主流基準測試中成績斐然。在SWE-bench Verified、τ2-Bench等測試中,其綜合表現(xiàn)超越了gpt-oss-20b、Qwen3-30B-A3B-Thinking-2507等模型,在相同和近似尺寸模型系列中斬獲開源SOTA分數(shù),充分彰顯了該模型的強大實力。

除了在基準測試中表現(xiàn)出色,GLM-4.7-Flash在實際應(yīng)用場景中也毫不遜色。在內(nèi)部編程實測中,無論是前端任務(wù)還是后端任務(wù),該模型都展現(xiàn)出了卓越的性能。不僅如此,官方還推薦用戶在中文寫作、翻譯、長文本處理、情感/角色扮演等通用場景中體驗GLM-4.7-Flash,相信其能夠為用戶帶來全新的使用感受和更好的效果。

隨著GLM-4.7-Flash的上線,上一代免費語言模型GLM-4.5-Flash也即將迎來下線。據(jù)悉,GLM-4.5-Flash將于2026年1月30日正式下線,用戶需及時將模型編碼更新為最新版本,以確保服務(wù)的正常使用。在GLM-4.5-Flash正式下線后,相關(guān)請求將會自動路由至GLM-4.7-Flash,保障用戶業(yè)務(wù)的連續(xù)性。