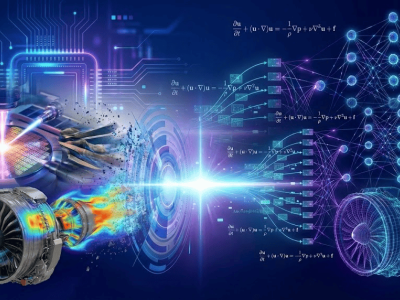

隨著具身智能技術(shù)的快速發(fā)展,傳統(tǒng)視覺-語言-動作(VLA)模型正面臨數(shù)據(jù)瓶頸與復(fù)雜場景適應(yīng)性挑戰(zhàn)。物理世界動態(tài)數(shù)據(jù)的稀缺性,成為制約機(jī)器人智能化水平提升的關(guān)鍵因素。在此背景下,螞蟻靈波宣布開源LingBot系列模型,通過構(gòu)建覆蓋感知、理解、模擬、行動的完整技術(shù)棧,為行業(yè)提供了一套可復(fù)用的具身智能基礎(chǔ)設(shè)施。

作為系列模型的核心突破,LingBot-VA首創(chuàng)"自回歸視頻-動作范式",通過融合視頻生成與運(yùn)動控制技術(shù),使機(jī)器人具備"先思后行"的決策能力。該模型采用Mixture-of-Transformers架構(gòu),將視覺推演(視頻流)與運(yùn)動控制(動作流)解耦設(shè)計(jì),既共享注意力機(jī)制又保持獨(dú)立計(jì)算。在執(zhí)行任務(wù)前,系統(tǒng)會先模擬未來3-5秒的世界狀態(tài)變化,結(jié)合實(shí)時傳感器反饋形成閉環(huán)修正,最終輸出最優(yōu)動作序列。這種設(shè)計(jì)使機(jī)器人在制作早餐、雙臂協(xié)作等長時序任務(wù)中的成功率提升20%,在RoboTwin 2.0基準(zhǔn)測試中突破90%成功率。

支撐LingBot-VA的是三大技術(shù)創(chuàng)新機(jī)制:閉環(huán)推演系統(tǒng)通過持續(xù)校準(zhǔn)模擬與現(xiàn)實(shí)的偏差,防止"幻覺漂移";異步推理管線實(shí)現(xiàn)動作預(yù)測與電機(jī)執(zhí)行的并行處理,將響應(yīng)延遲降低40%;自回歸訓(xùn)練框架使模型能夠從有限的真實(shí)數(shù)據(jù)中學(xué)習(xí)復(fù)雜場景的時空關(guān)聯(lián)。這些特性使該模型在LIBERO終身學(xué)習(xí)基準(zhǔn)上達(dá)到98.5%的平均成功率,顯著優(yōu)于傳統(tǒng)VLA模型。

同步開源的LingBot-Depth空間感知模型,通過多光譜融合技術(shù)解決了透明/反光物體的識別難題。該模型采用神經(jīng)輻射場(NeRF)與幾何約束相結(jié)合的方法,使透明物體抓取成功率從0提升至50%,在醫(yī)療試管插拔等精細(xì)操作中表現(xiàn)出色。其輸出的高精度深度信息可與LingBot-VLA無縫對接,形成"視覺-認(rèn)知-執(zhí)行"的增強(qiáng)回路。

作為機(jī)器人的"數(shù)字演練場",LingBot-World通過多階段訓(xùn)練架構(gòu)實(shí)現(xiàn)了近10分鐘的連續(xù)視頻生成能力。該模型采用時空注意力機(jī)制與動態(tài)物體建模技術(shù),有效解決了長時生成中的物體變形、場景崩潰等問題。在模擬環(huán)境中,機(jī)器人可進(jìn)行數(shù)萬次低成本試錯學(xué)習(xí),將真實(shí)世界訓(xùn)練效率提升3倍以上。這種"數(shù)字孿生"訓(xùn)練方式,為具身智能的規(guī)模化部署提供了關(guān)鍵支撐。

LingBot-VLA作為認(rèn)知中樞,基于2萬小時真實(shí)機(jī)器人操作數(shù)據(jù)訓(xùn)練,支持9種主流雙臂機(jī)器人構(gòu)型的零樣本遷移。該模型采用分層決策架構(gòu),將復(fù)雜任務(wù)分解為可執(zhí)行的子動作序列,在GM-100基準(zhǔn)測試中超越基線模型Pi0.5。其獨(dú)特的跨構(gòu)型適應(yīng)能力,使同一"大腦"可無縫切換至不同硬件平臺,顯著降低機(jī)器人系統(tǒng)的開發(fā)成本。

行業(yè)專家指出,螞蟻靈波的全棧開源策略打破了傳統(tǒng)具身智能研發(fā)的"煙囪式"局限。開發(fā)者既可單獨(dú)使用某個模塊解決特定問題,也能組合構(gòu)建完整系統(tǒng)。這種開放生態(tài)有望加速技術(shù)迭代,推動具身智能從實(shí)驗(yàn)室走向工業(yè)制造、醫(yī)療護(hù)理、家庭服務(wù)等真實(shí)場景。據(jù)測試數(shù)據(jù)顯示,采用LingBot系列模型的研發(fā)周期可縮短60%,工程化成本降低45%,為機(jī)器人大規(guī)模部署掃清了關(guān)鍵障礙。