近日,科技領域傳來新動態(tài),DeepSeek正對其網頁端和APP進行新功能測試,此次測試聚焦于全新的長文本模型結構,該結構可支持高達1M的上下文。不過,其API服務目前依舊保持為V3.2版本,僅支持128K上下文。

這一動作引發(fā)外界諸多猜測,不少人認為DeepSeek或許會在今年春節(jié)期間再次帶來驚喜,發(fā)布新模型,有望重現(xiàn)去年春節(jié)時引發(fā)行業(yè)轟動的盛況。此前,DeepSeek在模型研發(fā)方面就動作不斷,展現(xiàn)出強大的技術實力與創(chuàng)新能力。

今年1月12日,DeepSeek聯(lián)合北京大學共同完成了一篇頗具影響力的論文《Conditional Memory via Scalable Lookup:A New Axis of Sparsity for Large Language Models》(基于可擴展查找的條件記憶:大語言模型稀疏性的新維度),梁文鋒位列作者名單。論文聚焦于當前大語言模型存在的記憶力不足問題,創(chuàng)新性地提出了“條件記憶”這一概念,為解決該問題提供了新的思路與方向。基于此,行業(yè)普遍推測DeepSeek的下一代模型V4極有可能在今年春節(jié)前后正式亮相。

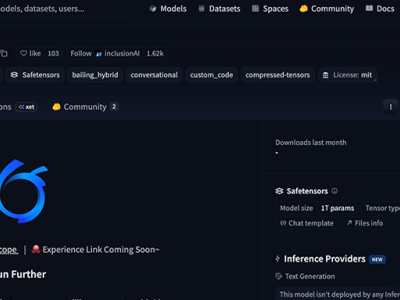

回顧去年12月1日,DeepSeek曾一次性發(fā)布兩個正式版模型,分別是DeepSeek-V3.2和DeepSeek-V3.2-Speciale。目前,官方網頁端、App以及API均已更新為正式版DeepSeek-V3.2,而Speciale版本則以臨時API服務的形式開放,主要用于社區(qū)評測與研究工作。

據了解,DeepSeek-V3.2在研發(fā)過程中有著明確的目標,即平衡推理能力與輸出長度,使其更貼合日常使用場景,例如問答場景以及通用Agent(智能體)任務場景。在公開的推理類Benchmark測試中,DeepSeek-V3.2展現(xiàn)出不俗的實力,達到了GPT-5的水平,僅稍遜于Gemini-3.0-Pro。與Kimi-K2-Thinking相比,V3.2的輸出長度大幅降低,有效減少了計算開銷,同時也顯著縮短了用戶的等待時間。