螞蟻集團近日宣布開源其最新研發的全模態大模型——Ming-Flash-Omni 2.0。該模型在視覺語言理解、語音可控生成、圖像生成與編輯等多個領域展現出卓越性能,成為開源社區中備受矚目的技術突破。

作為業界首個全場景音頻統一生成模型,Ming-Flash-Omni 2.0突破了傳統模型在音頻處理上的局限。它能夠在單條音軌中同時生成語音、環境音效和音樂,并通過自然語言指令實現音色、語速、語調、音量、情緒和方言的精準控制。在推理效率方面,該模型達到3.1Hz的極低幀率,支持分鐘級長音頻的實時高保真生成,在成本控制和性能表現上均處于行業領先地位。

全模態大模型的發展面臨通用性與專精性的平衡難題。開源模型在特定任務上往往難以媲美專用模型,但螞蟻集團通過持續投入和技術迭代,使Ming-Omni系列逐步突破這一瓶頸。早期版本構建了多模態能力基礎,中期版本驗證了規模增長帶來的性能提升,而2.0版本通過更大規模的數據訓練和系統性優化,在全模態理解與生成能力上達到開源領域領先水平,甚至在部分場景超越專用模型。

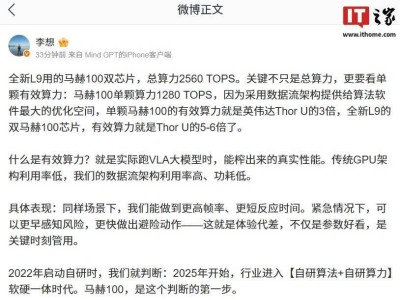

該模型基于Ling-2.0架構(MoE,100B-A6B)開發,圍繞"精準識別、精細控制、穩定生成"三大核心目標進行優化。在視覺領域,通過融合億級細粒度數據和難例訓練策略,顯著提升了對近緣物種、工藝細節和稀有文物的識別能力;音頻方面,支持語音、音效、音樂的同軌生成,并具備零樣本音色克隆功能;圖像編輯功能則強化了復雜場景的穩定性,支持光影調整、場景替換和一鍵修圖等操作,即使在動態場景中也能保持畫面連貫性。

百靈模型負責人周俊指出,全模態技術的核心在于通過統一架構實現多模態能力的深度融合。開源后,開發者可基于同一框架調用視覺、語音和生成能力,大幅降低多模型串聯的復雜度和開發成本。目前,Ming-Flash-Omni 2.0的模型權重和推理代碼已在Hugging Face等開源平臺發布,用戶也可通過螞蟻百靈官方平臺Ling Studio進行在線體驗和調用。

這一技術突破不僅為端到端多模態應用開發提供了統一能力入口,更推動了AI技術在實際業務中的規模化落地。隨著工具鏈和評測體系的不斷完善,全模態大模型有望在更多領域展現其變革性潛力。