2月13日消息,今日,螞蟻集團開源發(fā)布全球首個基于混合線性架構的萬億參數(shù)思考模型 Ring-2.5-1T,在長文本生成、數(shù)學推理與智能體任務執(zhí)行上達到開源領先水平,為智能體(Agent)時代的復雜任務處理提供高性能基礎支撐。

在生成效率上,Ring-2.5-1T在32K以上長文本生成場景中,對比上代模型訪存規(guī)模降低10倍以上,生成吞吐提升3倍以上。

在深度思考能力方面,該模型在國際數(shù)學奧林匹克競賽(IMO 2025)和中國數(shù)學奧林匹克(CMO 2025)自測均達到金牌水平(IMO 35分、CMO 105分)。

同時,可輕松適配Claude Code等智能體框架與OpenClaw個人AI助理,支持多步規(guī)劃與工具調用。

在多項權威基準測試中,Ring-2.5-1T 與 DeepSeek-v3.2-Thinking、Kimi-K2.5-Thinking、GPT-5.2-thinking-high、Gemini-3.0-Pro-preview-thinking-high、Claude-Opus-4.5-Extended-Thinking 等主流開源與閉源模型進行了系統(tǒng)對比,在數(shù)學推理、代碼生成、邏輯推理和智能體任務執(zhí)行等高難場景中達到開源領先水平。尤其在深度思考(Heavy Thinking)模式下,該模型在IMOAnswerBench、HMMT-25等數(shù)學競賽推理基準和LiveCodeBench-v6代碼生成基準中超越所有對比模型,展現(xiàn)了強大的復雜推理與跨任務泛化能力。

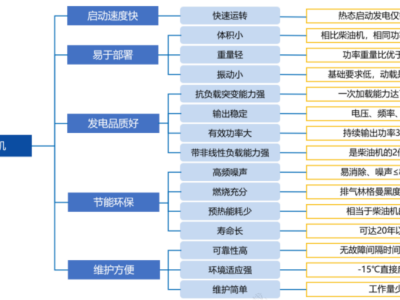

據(jù)了解,Ring-2.5-1T基于Ling 2.5架構,通過優(yōu)化注意力機制,顯著提升長文本推理的效率與穩(wěn)定性。模型激活參數(shù)規(guī)模從前代的 51B 提升至 63B,但在混合線性注意力架構的支持下,推理效率相比上一代大幅提升。

與僅具備 32B 激活參數(shù)的KIMI K2架構相比,在1T總參數(shù)量下,Ling 2.5架構在長序列推理任務中的吞吐表現(xiàn)依然優(yōu)勢顯著,且隨著生成長度增加,效率優(yōu)勢持續(xù)擴大。

目前,Ring-2.5-1T 的模型權重與推理代碼已在Hugging Face、ModelScope等主流開源平臺發(fā)布。官方平臺Chat體驗頁和API服務將在近期上線。

具體開源倉庫和體驗頁面如下(可點擊前往)

Hugging Face:

https://huggingface.co/inclusionAI/Ring-2.5-1T-FP8

ModelScope:

https://modelscope.cn/models/inclusionAI/Ring-2.5-1T-FP8