在人工智能領域,讓機器同時理解語言和圖像一直是科學家們努力突破的關鍵方向。近期,蒙特利爾大學Mila人工智能研究院、麥吉爾大學以及哥本哈根大學組成的聯合研究團隊,在這一領域取得了重大進展。相關研究成果以論文形式發表,讀者可通過arXiv編號2602.00462獲取完整內容。

研究團隊聚焦于一個基礎問題:當文字處理型AI系統接收圖像輸入時,其內部究竟發生了怎樣的變化?這類似于讓只熟悉中文的人突然面對英文單詞,需要探究大腦如何處理陌生符號。當前AI系統中,將大型語言模型(如ChatGPT類系統)與視覺系統通過簡單“翻譯器”連接,就能實現圖文協同理解。這個“翻譯器”可能只是簡單的數學轉換器,甚至僅是線性轉換,其簡單程度超出常規認知。

圖像與文字屬于完全不同的信息類型,如同音樂與繪畫的差異。為何文字處理系統能輕松理解圖像信息?這背后隱藏著怎樣的機制?為解開謎團,研究團隊開發了名為“LATENTLENS”的分析工具,它如同特殊眼鏡,能讓研究者觀察AI系統內部對視覺信息的處理過程。

研究團隊對十個不同視覺語言模型進行深入分析,結果令人驚訝。傳統分析方法嚴重低估了AI系統對視覺信息的理解能力,新方法顯示大部分視覺信息在AI系統各處理層都可被理解,比例高達72%,而傳統方法得出的比例僅為23% - 30%。研究還發現了“中層躍遷”這一有趣現象,即圖像信息進入語言模型時,并非以原始形式存在,而是直接躍升至更高級的理解層次。

對于AI系統如何理解世界,從圖像到語言的轉換過程十分復雜。目前成功的視覺語言模型采用特定設計:先用視覺編碼器(類似專業攝影師)分析圖像,將其轉換為數字化“視覺標記”,再通過連接器(類似翻譯官)轉換為語言模型可理解的格式,最后送入大型語言模型處理。連接器常是多層感知機(MLP),有時簡單到只是線性變換,如同用簡單公式轉換溫度單位。

這種簡單性引發了科學疑問:若圖像和語言信息類型完全不同,為何轉換如此簡單?是否意味著二者在深層次本質相通?為解答這些問題,科學家需要深入AI系統內部觀察其信息處理過程,就像醫生用X光機觀察人體內部結構,AI研究者需要特殊工具觀察算法“思維過程”。

傳統分析方法主要有“嵌入透鏡”和“邏輯透鏡”。“嵌入透鏡”通過比較視覺標記與語言模型詞匯表中單詞的相似程度判斷其含義,如同通過比較陌生物體與已知物體猜測身份;“邏輯透鏡”通過觀察模型各層輸出預測理解信息處理過程。但這兩種方法都只能提供單個詞匯級別解釋,準確率不高,如同用單個詞匯描述復雜畫作,無法完整表達內涵。

認識到傳統方法不足后,研究團隊開發了LATENTLENS。其工作原理可這樣比喻:傳統方法如同用字典理解外語,只能逐詞查找;而LATENTLENS如同精通多種語言的同聲傳譯員,能理解完整句子和復雜語境。具體而言,LATENTLENS先建立巨大“語境數據庫”,從Visual Genome數據集收集近300萬個圖像描述句子,用語言模型編碼記錄各詞在不同層次、語境的表示,如同創建詳細語言地圖記錄各詞“坐標位置”。分析視覺標記時,LATENTLENS在語境數據庫中尋找最相似表示,且不是簡單匹配單個詞匯,而是找到包含相似詞匯的完整句子,如分析表示建筑物的視覺標記時,可能找到“大型紅磚建筑有很多窗戶”的完整描述。

句子級別描述能提供更豐富語義信息,如同用生動描述解釋畫作,遠超單個標簽。通過比較不同層次語境表示,LATENTLENS還能揭示信息在模型中的處理軌跡。為驗證分析結果準確性,研究團隊開發了自動化評判系統,用GPT - 5作為“裁判”,讓其觀看圖像和相應描述,判斷描述是否準確反映圖像內容,該評判系統能區分具體匹配、抽象匹配和全局匹配三種類型。研究團隊還進行人工驗證,讓真人評估者打分,結果顯示AI裁判和人類評估者一致性達68%,表明自動評判系統可靠。通過完整分析框架,研究團隊系統性評估了不同模型、層次的視覺理解能力,分析了九個不同模型組合(三種語言模型配合三種視覺編碼器)及一個現成商業模型,共十個系統。

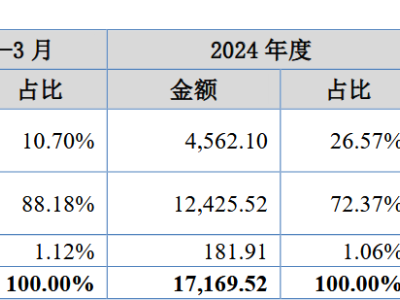

使用LATENTLENS分析這些AI系統時,結果超出預期。傳統方法顯示僅23% - 30%的視覺標記可解釋,而LATENTLENS分析發現平均72%的視覺標記高度可解釋,且這種高度可解釋性在模型各處理層次都存在,打破了之前認為只有特定層次能獲得有意義解釋的觀念。研究團隊還發現不同模型架構存在差異,使用CLIP和SigLIP視覺編碼器的模型可解釋性更高,而使用DINOv2編碼器的模型雖在圖像描述任務上表現較差,但視覺標記可解釋性同樣很高。DINOv2在訓練時未使用任何文本監督,完全通過自監督學習理解視覺世界,這一發現表明視覺信息和語言信息在深層次相通,即使未接受語言訓練的視覺系統,其學習表示也能與語言表示建立有意義對應關系。

研究團隊分析了可解釋標記的類型分布,約65%屬于“具體”類型,直接描述圖像可見內容,如顏色、形狀、物體等;約19%屬于“抽象”類型,描述更高層次概念,如情感、功能、風格等;剩余16%屬于“全局”類型,描述圖像其他部分內容。這表明AI系統不僅能識別具體視覺元素,還能進行一定程度的抽象推理,理解圖像更深層含義。

在深入分析中,研究團隊發現了“中層躍遷”現象,改變了對AI系統內部信息處理方式的理解。按直覺,視覺信息進入語言模型后會從低級視覺特征逐漸轉換為高級語義理解,如同人類看東西先看到線條和顏色,再識別形狀、物體,最后理解含義。但LATENTLENS分析顯示,視覺標記剛進入語言模型時(輸入層),并非與同層文本表示最相似,而是與模型中間層(如第8層到第16層)文本表示最相似,如同學生跳級,視覺信息剛“入學”就達到相當于四五年級的理解水平。進一步分析發現,視覺標記在語言模型不同層次變化小,保持相對穩定表示,而文本標記經語言模型處理會發生顯著變化,早期層次更多表現為詞匯級別表示,中間層次逐漸獲得豐富語境信息。這暗示視覺編碼器和連接器組合已將原始視覺信息提升到高級語義層次,視覺信息進入語言模型時已不是原始像素信息,而是經過高度加工的語義表示。研究團隊通過分析視覺標記的L2范數發現更多有趣細節,視覺標記的L2范數通常比文本標記大得多,有時大1 - 2個數量級,且這種差異不是由少數異常值引起,而是所有維度數值普遍增大,如同視覺信息被放大音量,但保持原有旋律結構。

研究團隊對十個不同視覺語言模型進行了全面對比,為分析不同AI系統視覺理解能力提供了珍貴見解。語言模型方面,選擇了OLMo - 7B、LLaMA3 - 8B和Qwen2 - 7B三種代表性模型;視覺編碼器方面,選擇了CLIP - ViT、DINOv2和SigLIP三種不同訓練方法的系統,CLIP和SigLIP使用視覺 - 語言聯合訓練,DINOv2完全基于自監督學習,未使用文本信息。通過九種不同組合(3×3)及現成商業模型Qwen2 - VL - 7B - Instruct,研究團隊系統分析了不同架構選擇對視覺理解能力的影響。結果顯示,所有模型組合使用LATENTLENS分析時都展現出很高可解釋性,最差組合可解釋性也達60%以上,最好組合超過80%,表明高度視覺可解釋性是這類AI系統普遍特征。不同語言模型比較中,OLMo模型與EmbeddingLens和LogitLens結合使用時表現更好,但在LATENTLENS分析中所有模型表現都不錯,說明LATENTLENS能更好揭示不同模型共同特征。視覺編碼器選擇也有影響,使用CLIP和SigLIP的模型在各種分析方法中表現良好,使用DINOv2的模型雖圖像描述任務表現較差,但視覺標記可解釋性同樣很高,表明視覺理解和語言描述能力可能是相對獨立的能力。現成商業模型Qwen2 - VL - 7B - Instruct經過完整多階段訓練,包括指令調優,圖像描述任務表現出色,LATENTLENS分析顯示其視覺標記同樣具有很高可解釋性,但中層躍遷現象不如控制實驗中的模型明顯,可能是多輪訓練中語言模型權重調整改變了內部信息處理方式。

為更深入理解AI系統處理視覺信息的方式,研究團隊對LATENTLENS找到的最佳匹配詞匯進行了詳細語言學分析。詞性分布方面,名詞占比最大,約45% - 50%,專有名詞占約10% - 20%,動詞占10% - 15%,形容詞約占5%,這種分布在不同處理層次保持相對穩定,表明AI系統在各層次都保持對視覺世界的一致理解框架,名詞主導地位說明AI系統主要識別和理解圖像中的實體對象。視覺屬性分析中,顏色詞最常見,早期層次占約5% - 6%,隨處理層次加深逐漸下降到約3%,暗示AI系統早期更多關注原始視覺特征,隨處理深入逐漸轉向抽象語義理解;形狀和紋理詞匯相對較少,都不到1%,可能因這類屬性需更復雜視覺分析或訓練數據中這類描述較少。可解釋標記的語義類型分布顯示,約65%的標記屬于“具體”類型,19%屬于“抽象”類型,16%屬于“全局”類型,表明AI系統主要進行基于感知的直接理解,但具備一定抽象推理能力,抽象類型標記存在說明AI系統不僅能識別“是什么”,還能理解“意味著什么”。研究團隊還進行了一系列控制實驗,改變訓練數據詳細程度,從詳細多句子描述改為簡單單句描述,可解釋性仍保持較高水平;嘗試不同連接器架構,從復雜多層網絡簡化為簡單線性變換,結果同樣令人鼓舞,表明視覺標記高度可解釋性是穩健現象,不依賴特定訓練設置或架構選擇。

LATENTLENS的發現不僅在學術上有重要意義,在實際應用方面也潛力巨大,為改進現有AI系統和開發新應用提供了重要指導。在AI系統可解釋性方面,LATENTLENS提供了全新分析工具,傳統AI系統常被視為“黑盒子”,只能看到輸入輸出,無法理解內部處理過程,而LATENTLENS能深入AI系統內部,觀察其理解和處理視覺信息的方式。這種可解釋性在醫療診斷、自動駕駛等關鍵應用領域非常重要,醫生需知道AI系統診斷結果的原因,自動駕駛系統需理解如何識別和理解路況,LATENTLENS提供的分析框架可幫助開發者更好理解和改進這些系統。研究團隊還展示了LATENTLENS在處理文本圖像方面的出色表現,當圖像中包含文字時,LATENTLENS能準確識別和描述文字內容,如分析包含“CAFE”標志的圖像區域時,能找到包含“cafe”詞匯的最佳匹配句子,這種能力在文檔處理、街景理解等應用中非常有用。在模型開發方面,這些發現為設計更高效的視覺語言模型提供了啟示,既然簡單線性連接器就能實現良好效果,就無需設計過于復雜架構,可降低計算成本,提高模型訓練效率。中層躍遷現象的發現也為模型優化提供了新思路,設計連接器時可考慮讓視覺信息更直接映射到合適語義層次。研究團隊還探索了動態生成描述的可能性,傳統LATENTLENS依賴預先構建的語境數據庫,但通過進化搜索算法可動態生成更準確描述,這種方法在85%的案例中能提高匹配質量,為未來系統優化提供了新方向。在評估方法方面,LATENTLENS提供的自動化評判框架也具有實用價值,傳統評估AI系統視覺理解能力需大量人工標注,成本高且效率低,LATENTLENS的自動評判系統與人類評判一致性達68%,可大大降低評估成本。

針對讀者可能關心的問題,研究團隊給出了解答。LATENTLENS和傳統分析方法的主要區別在于,傳統方法只能提供單個詞匯級別解釋,準確率低,而LATENTLENS通過比較視覺標記與豐富語境中的文本表示,能提供完整句子級別描述,準確率高。中層躍遷現象是指視覺信息剛進入語言模型時,不是與同層文本表示最相似,而是與中間層文本表示最相似,如同學生跳級,說明視覺編碼器已將原始圖像提升到高級語義層次。沒有語言訓練的DINOv2模型能被很好解釋,表明視覺理解和語言理解可能基于某些共同認知基礎,如同不同語言的人看到蘋果都能理解它是水果,視覺和語言在深層次相通。