近日,一款名為DeepSeek V4的開源AI模型引發科技圈熱議。這款被網友稱為“開源新王”的模型,據傳在多項基準測試中超越了Claude Opus 4.5和GPT-5.2等頂尖閉源模型,尤其在編程能力上展現出驚人實力。盡管官方尚未正式發布,但泄露的測試數據已讓整個AI社區沸騰。

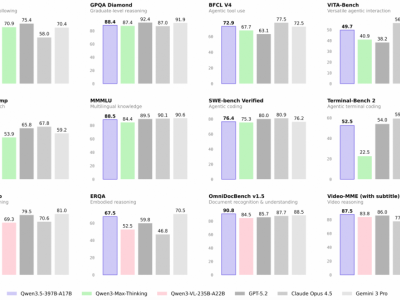

根據網絡流傳的測試結果,DeepSeek V4在SWE-bench Verified編程基準測試中取得了83.7%的得分,超越了Claude Opus 4.5的80.9%和GPT-5.2的80%。這一成績若經證實,將直接改寫當前最強代碼模型的排名。更令人震驚的是,該模型在AIME 2026數學競賽測試中達到99.4%的準確率,在FrontierMath Tier 4前沿數學推理測試中取得23.5%的得分,是GPT-5.2的11倍。

技術專家分析指出,DeepSeek V4的突破不僅體現在分數上。該模型具備100萬token的上下文處理能力,配合全新的Engram條件記憶機制,使其能夠理解大型代碼庫中文件間的復雜關聯。這種“全倉庫級推理能力”對企業級軟件開發具有革命性意義——開發者可以依賴AI理解整個項目結構,在正確位置插入新功能或修復bug,而無需擔心上下文丟失問題。

然而,這些驚人的測試數據也引發了質疑。Epoch AI等機構證實,FrontierMath數據集的評估權限僅開放給特定機構,網絡流傳的分數存在偽造可能。更有專家指出,在官方評分系統下,AIME測試的最高分應為100%(120/120),而99.4%的得分存在統計異常。這些爭議使得DeepSeek V4的真實性能仍籠罩在迷霧之中。

盡管如此,DeepSeek V4的潛在影響力已不容忽視。據知情人士透露,該模型可能采用2000億參數架構,但未使用與北大聯合開發的Engram記憶機制。灰度測試顯示,其API文檔標注的上下文長度仍為128K,與宣稱的100萬token存在差距。這種“低調測試”策略被解讀為技術驗證階段的重要步驟。

在模型架構層面,DeepSeek持續推動創新。meta科學家Zhuokai Zhao的研究表明,當前前沿稀疏專家模型已形成標準配方:MLA架構結合sigmoid激活函數,配合共享專家模塊和無輔助損失設計,正在成為行業新標準。而DeepSeek在V3.2版本后,持續在模型架構、記憶機制和視覺推理等領域探索,為V4的突破奠定了技術基礎。

這場開源與閉源模型的競爭,正演變為技術理念的交鋒。DeepSeek V4若能兌現承諾,將以開放權重模式打破閉源模型的技術壟斷,為全球開發者提供低成本、高性能的替代方案。其引發的討論,已超越單純的技術比較,成為AI發展路徑選擇的重要參照。